第一步:最常见的原因 - 浏览器兼容与缓存问题

这是新手最容易遇到,也最容易解决的问题。

(图片来源网络,侵删)

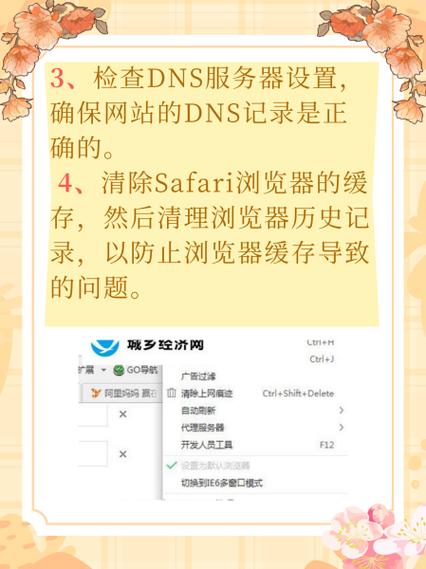

-

清除浏览器缓存和Cookie:

- 原因:浏览器可能缓存了旧的JS文件或页面数据,导致新的采集功能无法正常加载和执行。

- 解决方法:按

Ctrl + F5(或Cmd + Shift + Ron Mac) 强制刷新页面,如果还不行,请彻底清除浏览器的缓存和Cookie,然后重新登录DedeCMS后台。

-

更换浏览器或使用无痕模式:

- 原因:某些浏览器插件(如广告拦截器、脚本拦截器)可能会阻止DedeCMS后台的JavaScript文件运行,导致“没有反应”。

- 解决方法:

- 尝试使用其他浏览器(如 Chrome, Firefox, Edge)进行操作。

- 在当前浏览器中打开“无痕/隐私模式”,再进行采集操作,如果可以,说明就是插件的问题,请逐一禁用可疑插件。

-

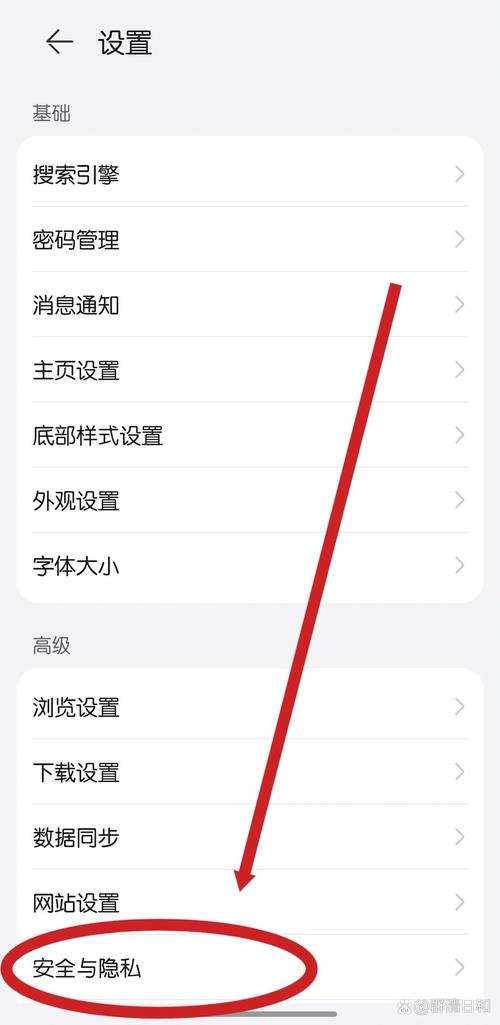

检查JavaScript是否被禁用:

- 原因:DedeCMS的采集功能,尤其是选择“使用规则”的高级采集, heavily 依赖JavaScript。

- 解决方法:确保你的浏览器启用了JavaScript。

第二步:DedeCMS后台与权限问题

如果第一步无效,问题可能出在DedeCMS本身。

(图片来源网络,侵删)

-

检查采集入口页面是否完整:

- 现象:点击“开始采集”后,页面没有任何反应,甚至连一个加载中的提示都没有。

- 原因:通常是后台模板文件

/dede/templets/co_add_step2.htm或相关的JS文件/dede/js/co_step2.js损失、权限不足或被修改过。 - 解决方法:

- FTP/SFTP登录:用你的FTP工具连接到服务器。

- 检查文件:进入

/dede/templets/目录,确认co_add_step2.htm文件是否存在且大小正常,同样,检查/dede/js/co_step2.js文件。 - 修复文件:如果文件缺失或大小异常(比如只有几KB),说明文件损坏或丢失,你需要从官方DedeCMS完整安装包中找到这两个文件,重新上传到你的网站服务器上,覆盖原有文件。

- 检查权限:确保这两个文件的权限是

644,目录的权限是755。

-

检查PHP相关函数是否被禁用:

- 原因:采集功能需要调用PHP的一些核心函数,如果服务器禁用了这些函数,采集程序将无法执行。

- 解决方法:

- 创建一个PHP文件:在你的网站根目录下创建一个名为

phpinfo.php的文件,内容为<?php phpinfo(); ?>。 - 访问检查:通过浏览器访问

你的域名/phpinfo.php。 - 搜索函数:在页面中搜索

allow_url_fopen和curl。allow_url_fopen必须为On,如果为Off,采集将无法获取远程网页内容。curl模块必须被加载(--with-curl),这是DedeCMS采集推荐的扩展,比file_get_contents更强大、更稳定。

- 联系主机商:如果这些选项被禁用,你需要联系你的虚拟主机或服务器提供商,让他们帮你开启,这是最常见的服务器环境问题之一。

- 创建一个PHP文件:在你的网站根目录下创建一个名为

第三步:服务器环境与PHP配置问题

如果DedeCMS文件正常,但服务器环境不支持,采集同样会失败。

-

执行时间限制:

(图片来源网络,侵删)

(图片来源网络,侵删)- 原因:采集一个大型网站可能需要很长时间,如果PHP的

max_execution_time设置得太短(如30秒),程序在执行到一半时就会被服务器强制中断,导致前端看起来“没有反应”。 - 解决方法:

- 修改

php.ini:如果你有服务器root权限,找到php.ini文件,修改max_execution_time = 300(或更大的值,单位是秒)。 - 在代码中设置:如果没有权限修改

php.ini,可以在DedeCMS的采集相关文件(如/dede/co.php)的最顶部添加一行代码:set_time_limit(0); // 设置脚本执行时间为不限制

注意:修改核心文件有风险,操作前请备份。

- 修改

- 原因:采集一个大型网站可能需要很长时间,如果PHP的

-

内存限制:

- 原因:采集和解析大量HTML内容会消耗大量内存。

memory_limit太小,会导致PHP内存溢出,程序崩溃。 - 解决方法:同样在

php.ini中找到memory_limit,将其调高,memory_limit = 256M或512M。

- 原因:采集和解析大量HTML内容会消耗大量内存。

-

安全软件拦截:

- 原因:服务器上安装了安全狗、云锁等安全软件,可能会认为DedeCMS的采集行为是“高频请求”或“恶意攻击”,从而拦截操作。

- 解决方法:登录你的服务器安全软件管理后台,查看拦截日志,将DedeCMS的后台目录(通常是

/dede/)添加到白名单中,并放行相关操作。

第四步:目标网站问题

问题不在你这里,而在你要采集的网站那里。

-

目标网站设置了反爬虫机制:

- 原因:很多网站会检测访问频率、User-Agent等信息,如果你的采集请求过于频繁或请求头不正常,网站会直接拒绝返回内容,导致你的采集程序卡住。

- 解决方法:

- 设置采集间隔:在DedeCMS的采集规则中,设置合理的“发布间隔”(例如3-5秒),模拟人工操作,避免被封。

- 更换User-Agent:在采集规则的高级选项中,可以设置自定义的User-Agent,使其看起来像正常的浏览器访问。

- 使用代理IP:如果IP被封锁,可以考虑使用代理IP池进行采集。

-

目标网站结构变更:

- 原因:如果采集规则是之前创建的,现在目标网站的HTML结构发生了变化,DedeCMS的采集器就无法正确解析内容,导致在解析步骤卡住,前端看起来没有反应。

- 解决方法:需要重新创建或修改采集规则,使用“选择”功能,手动重新定位需要采集的内容区域(如标题、正文、作者等)。

总结与排查清单

当你遇到“没有反应”时,不要慌张,按这个清单来检查:

- [前端] 强制刷新页面 (

Ctrl+F5),清除浏览器缓存。 - [前端] 尝试无痕/隐私模式,或更换浏览器。

- [程序] 检查DedeCMS后台文件

/dede/templets/co_add_step2.htm和/dede/js/co_step2.js是否存在且完整(从官方包覆盖)。 - [服务器] 检查PHP配置

allow_url_fopen是否为On,curl模块是否已加载(通过phpinfo.php检查)。 - [服务器] 联系主机商,确保服务器没有拦截DedeCMS后台的请求。

- [服务器] 尝试增加PHP的

max_execution_time和memory_limit。 - [规则] 检查采集规则是否过时,是否设置了合理的采集间隔。

- [规则] 尝试新建一个最简单的采集规则,只采集一个测试页面,看是否成功。

按照这个流程,90%以上的“没有反应”问题都可以得到解决,如果以上所有步骤都尝试过仍然无效,那么很可能是你的DedeCMS版本存在未知的Bug,建议升级到最新的稳定版或寻求专业的技术支持。